Inteligencia Artificial

6 nov 2024

|

Lectura: 8 min

MangoByte Staff

Transformación Digital en los Negocios | MangoByte

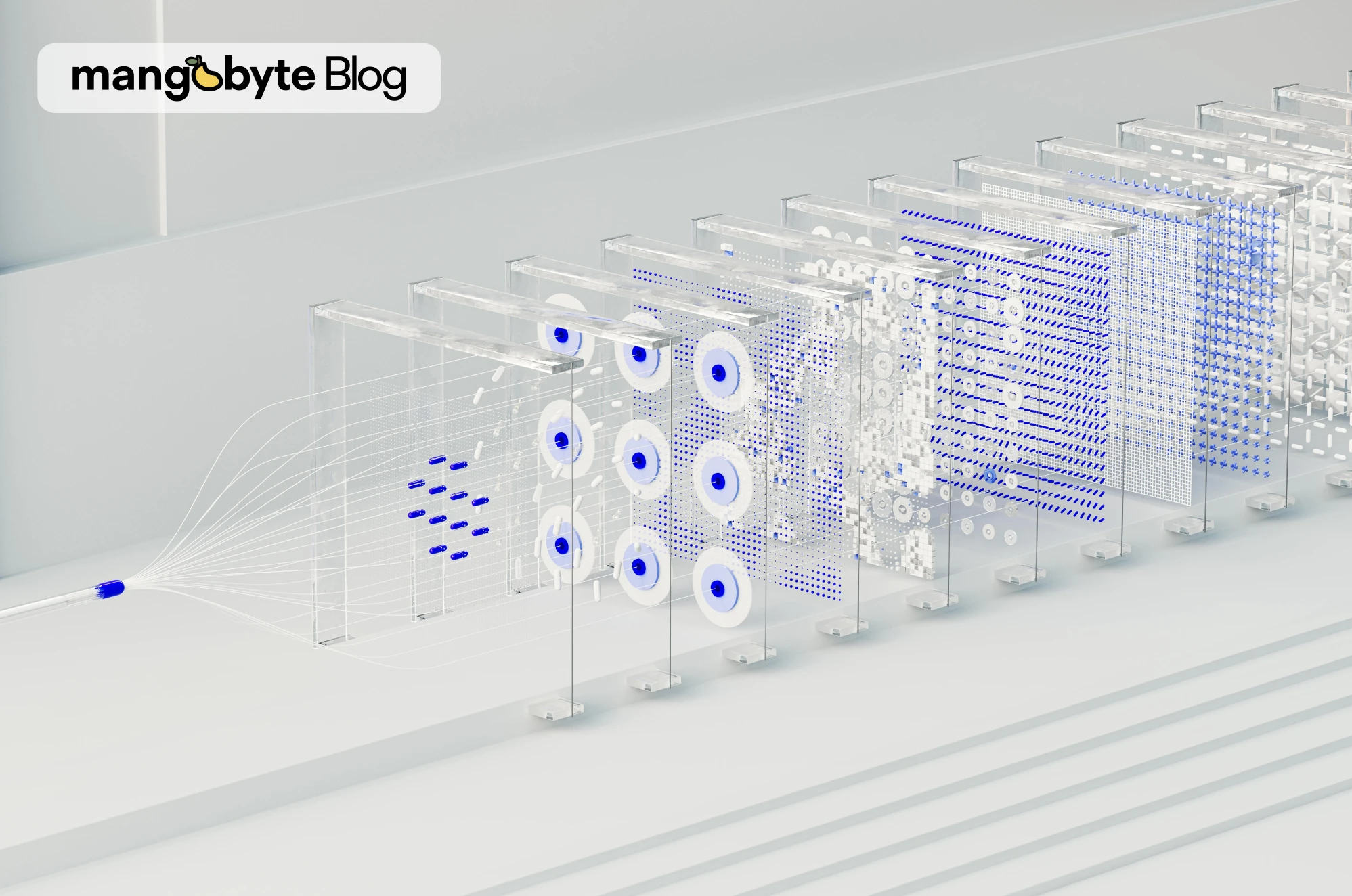

Para que un modelo de inteligencia artificial (IA) pueda aprender, necesita grandes cantidades de datos. En el proceso de entrenamiento, la IA analiza estos datos repetidamente para identificar patrones y extraer conocimiento que le permita adaptarse a distintos contextos. Este proceso es lo que permite que un modelo de IA desarrolle habilidades complejas y pueda resolver problemas con precisión. Sin datos, la IA no podría ofrecer resultados útiles ni ajustarse a nuevas situaciones.

Organizar los datos necesarios para entrenar modelos de IA es una tarea compleja que depende de varios componentes clave. Entre ellos se encuentran Common Crawl, una biblioteca abierta que recopila grandes volúmenes de datos de internet; LAION-5B, un conjunto de datos elaborado a partir de esa biblioteca para entrenar modelos de IA; y CLIP, un modelo que evalúa la relación entre imágenes y texto. Juntos, estos elementos forman la base sobre la que la IA “aprende” y adquiere conocimiento del mundo. Sin embargo, su uso también plantea dilemas éticos que merecen una reflexión más profunda.

Common Crawl: La Biblioteca de Internet

Common Crawl es un proyecto sin fines de lucro que actúa como una “biblioteca pública” de internet, recopilando grandes volúmenes de datos accesibles públicamente. A través de un proceso automático conocido como web scraping, recorre millones de sitios web cada mes y guarda su contenido: artículos, publicaciones de blogs, enlaces a imágenes y otros datos disponibles al público. Esto permite que Common Crawl funcione como un archivo masivo de la web, que se utiliza para la investigación, el análisis de tendencias y, en este caso, el entrenamiento de modelos de IA.

El proceso automatizado de Common Crawl permite recopilar datos a gran escala sin intervención humana directa. Sin embargo, esta recolección masiva también acumula contenido potencialmente problemático, como información personal o material explícito. Estos riesgos, comunes en la recopilación automatizada, son difíciles de controlar completamente con filtros automáticos, lo que plantea desafíos importantes para asegurar un uso responsable y ético de estos datos.

LAION-5B: Un Dataset para Entrenar IA

Para aprovechar esta enorme base de datos en bruto, surge LAION-5B, un proyecto sin fines de lucro que selecciona y estructura los datos de Common Crawl para el entrenamiento de modelos de IA. Mientras que Common Crawl actúa como un archivo general de la web, LAION-5B utiliza un proceso automatizado para identificar imágenes y sus textos asociados en las páginas web, formando pares de imagen y texto.

El propósito de LAION-5B es claro: enseñar a los modelos de IA a relacionar imágenes con palabras y frases, permitiendo que la IA “vea” y “comprenda” el contenido visual. Para construir un dataset de esta escala, los creadores de LAION-5B recurrieron a un modelo de IA llamado CLIP, que asigna una puntuación de similitud a cada par de imagen y texto para medir qué tan bien se relacionan. En el dataset final se incluyen únicamente los pares que superaron el valor mínimo de similitud, establecido por el equipo de LAION, alcanzando así un total de 5.8 mil millones de pares.

CLIP: Midiendo la Coherencia entre Imagen y Descripción

CLIP es un modelo de IA desarrollado por OpenAI que asigna una puntuación a la relación entre una imagen y un texto, evaluando qué tan bien coinciden. Entrenado con millones de ejemplos de imágenes y descripciones, CLIP ha aprendido a identificar patrones y a "comprender" las relaciones entre elementos visuales y palabras o frases.

Sin embargo, hay una falta de transparencia significativa en el funcionamiento interno de CLIP. No solo el proceso exacto mediante el cual CLIP calcula estas puntuaciones es un sistema cerrado, sino que tampoco se tiene información detallada sobre los datos específicos que OpenAI utilizó para entrenar a CLIP, ni sobre los criterios exactos que le enseñaron a identificar coherencia. Esto significa que los usuarios de CLIP, como el equipo de LAION, dependen de un modelo que asigna calificaciones "de relevancia" sin una visión clara de los fundamentos que determinan esos criterios, lo que introduce un dilema ético y práctico.

Para crear el dataset final, el equipo de LAION también tuvo que definir un umbral de similitud, un valor mínimo a partir del cual un par se considera suficientemente relevante para ser incluido en el dataset. Esta decisión se vuelve en gran medida arbitraria y puede tener un impacto considerable: no existe un criterio universal ni completamente transparente para definir el punto de corte ideal. Por ejemplo, en LAION-5B, un cambio mínimo en el umbral de 0.26 a 0.27 puede excluir hasta un 16% de los pares, lo que equivale a más de 937 millones de pares de imagen y texto.

La falta de claridad sobre los datos y criterios de entrenamiento de CLIP, junto con la necesidad de tomar decisiones de corte basadas en un sistema opaco, plantea importantes preguntas sobre la objetividad y precisión del dataset resultante. Al depender de un umbral arbitrario en un sistema cerrado, la calidad de datasets como LAION-5B queda sujeta a interpretaciones difíciles de auditar. Esto abre un debate crítico sobre la confiabilidad de estos datos para entrenar modelos de IA a gran escala.

Dilemas Éticos en la Recolección de Datos Públicos

La creación de datasets como LAION-5B plantea dilemas éticos que no pueden ignorarse, en especial en torno a la privacidad, el consentimiento y el sesgo cultural. Aunque Common Crawl recopila datos públicamente accesibles, muchas personas que publican en internet no anticipan que su contenido pueda ser utilizado para entrenar modelos de IA. Esto plantea la pregunta: ¿es ético usar contenido “público” para fines como el entrenamiento de IA sin un consentimiento explícito? En un mundo donde la privacidad digital es cada vez más valorada, el uso de estos datos puede erosionar la confianza pública en la tecnología.

Otro desafío es el sesgo cultural y lingüístico. Common Crawl extrae predominantemente de sitios en inglés y de dominios occidentales, lo que hace que LAION-5B herede una perspectiva limitada del mundo. Más del 60% de los datos provienen de fuentes occidentales, y un 46% del contenido total está en inglés, una cifra que contrasta con el 20% de la población mundial que habla el idioma. Este sesgo significa que los modelos entrenados en LAION-5B pueden reflejar una visión cultural restringida, ignorando grupos y realidades culturales menos representadas. Además, estos sesgos se amplifican a medida que los modelos basados en estos datos se implementan en aplicaciones globales, generando un ciclo de retroalimentación que perpetúa prejuicios y desventajas culturales.

El Riesgo del Contenido Dañino en Datasets Masivos

Uno de los mayores riesgos en la recopilación masiva de datos es la inclusión de contenido dañino e incluso ilegal, como imágenes violentas, explícitas o sensibles, que pueden terminar en los datasets dada la falta de una revisión exhaustiva. Este fue el caso de LAION-5B, que en marzo de 2022 enfrentó fuertes críticas cuando se descubrió que su dataset incluía material no solo inapropiado, sino también potencialmente dañino para quienes usaban el modelo y para el público en general. La controversia fue tan seria que el acceso al dataset se retiró temporalmente para implementar controles adicionales y mejorar los filtros de calidad.

El hecho de que este tipo de contenido haya pasado los filtros automatizados plantea una cuestión urgente: ¿qué tan confiables son los procesos automáticos, como los de CLIP, para identificar y excluir material sensible? Y, aún más importante, ¿qué tanto debemos depender de ellos? En un dataset de la magnitud de LAION-5B, que incluye 5.8 mil millones de pares de imagen y texto, la revisión manual es simplemente imposible. Se estima que, si una persona dedicara solo un segundo a revisar cada imagen durante ocho horas al día, cinco días a la semana, tomaría aproximadamente 781 años para cubrir todo el dataset. Esta cifra no solo refleja la escala monumental del dataset, sino que también subraya el riesgo constante de que contenido dañino pase desapercibido, incluso con filtros automáticos.

La inclusión de contenido problemático no es solo un tema de “errores en el sistema”; tiene un impacto directo en la sociedad y en la confianza pública en la IA. Un modelo de IA entrenado en datos problemáticos puede producir resultados sesgados, ofensivos o insensibles, y puede normalizar el tratamiento de contenido inapropiado como parte de sus “aprendizajes”. En aplicaciones como motores de búsqueda de imágenes o sistemas de recomendación, los usuarios podrían verse expuestos a material explícito sin advertencia, afectando la seguridad y la reputación de la IA y de las organizaciones que la desarrollan.

Ante esta situación, LAION no solo eliminó temporalmente el acceso al dataset, sino que también lanzó una versión revisada llamada Re-LAION en octubre de 2022. Esta versión implementa filtros avanzados y ha sido desarrollada en colaboración con organizaciones especializadas en ética y estándares de IA, como Partnership on AI y la Universidad de Stanford, para asegurar que los filtros sean lo suficientemente precisos como para detectar contenido inapropiado de manera confiable.

Aunque Re-LAION-5B ha implementado medidas importantes para mejorar la seguridad y ética de su contenido, ningún sistema de filtrado es completamente infalible. La detección y eliminación de contenido inapropiado en datasets masivos sigue siendo un desafío constante, que requiere actualizaciones y ajustes continuos. Re-LAION-5B representa un avance hacia conjuntos de datos más seguros, pero no garantiza la eliminación total de contenido inapropiado. Resolver estos problemas no depende únicamente de mejoras tecnológicas, sino también de establecer regulaciones, auditorías y una cultura de responsabilidad en el uso de datos masivos. Este esfuerzo es solo el inicio de una solución; para garantizar una IA ética y confiable, se necesita un control riguroso en cada paso de su desarrollo.

El Takeaway

La creación de datasets masivos como LAION-5B representa un gran paso en el desarrollo de la inteligencia artificial. Estos conjuntos de datos ofrecen a los modelos la información necesaria para realizar tareas complejas, como reconocer imágenes y entender el contexto, haciendo que la IA sea cada vez más útil y relevante en una amplia variedad de industrias. Sin embargo, los métodos y decisiones involucrados en la construcción de estos datasets nos llevan a reflexionar sobre los dilemas éticos de la IA y sobre cómo equilibrar innovación y responsabilidad.

Resolver estos dilemas no es simple. Requiere tanto mejoras tecnológicas que aumenten la transparencia y diversidad de los datos, como un compromiso ético en la comunidad de IA. El camino hacia una IA responsable no se trata solo de perfeccionar modelos, sino de desarrollar sistemas que respeten y reflejen los valores de una sociedad diversa. A medida que avancemos en esta área, la transparencia, la inclusión y un compromiso con la ética serán esenciales para garantizar que la IA aporte valor de manera justa y confiable.

En MangoByte creemos en el uso responsable y sostenible de la tecnología. Contáctanos hoy mismo para desarrollar soluciones a la medida que reflejen tus valores y promuevan un impacto positivo en tu organización.